Wstęp

Temat licencjonowania i wyceny wartości oprogramowania przewija się często w moich projektach. Bywam nie raz proszony o wycenę posiadanego oprogramowania co, jak nie trudno się domyśleć, nie jest proste. Powszechnym zjawiskiem jest zawyżanie lub zaniżanie tej wartości, zależnie od tego do czego wynik wyceny zostanie użyty. Tam gdzie przedmiotem wyceny są posiadane aktywa, wyceny są często zawyżane przez sprzedającego udziały a zaniżane przez ich nabywcę.

Bardzo często podejmowane są próby bazowania na cenach transakcyjnych, jednak są to wyceny obarczone przypadkowością, gdyż są to tak naprawdę wyceny spekulacyjne, obarczone wpływem kontekstu każdej transakcji. W momencie zakupu licencji (lub praw majątkowych) nie dysponujemy wiedzą, jaką mamy np. po kilku latach gdy wyceniana jest np. firma. Typowe próby szacowania, to podejmowana ocena na ile wyceniane oprogramowanie “przysłużyło się”, jaki miało wpływ, do uzyskiwanych przychodów firmy.

Aksjomatem jest tu uznanie, że wartości niematerialne i intelektualne, bo tak najczęściej klasyfikowane jest oprogramowanie, to coś co przyczynia się do zysków i podlega wycenie jako procent tej wartości. Po pierwsze trzeba wykazać, że faktycznie sie przyczynia, a potem wykazać udział tego “przyczyniania się” na tle innych czynników mających wpływ na przychody (np. także inne oprogramowanie).

Trudności związane ze stosowaniem tego typu metod opisuje między innymi autor cytowanego poniżej artykułu.

Próby potwierdzenia zasady 25% na danych empirycznych przynoszą umiarkowane efekty, choć wyniki uśrednione często koncentrują się w okolicach 25%, to zmienność uzyskanych wyników prowadzi do uzyskania w różnych branżach, różnych poziomów licencji, najczęściej w przedziale 10- 50% zysku operacyjnego.

Podsumowując, Zasada 25% jest jednym z wielu narządzi do ustalenia optymalnej opłaty licencyjnej i tak powinna być traktowana i wykorzystywana ? zawsze wtedy, kiedy jest na to uzasadnienie. Choć zasada ta jest w pewnym stopniu uwiarygodniona analizami empirycznymi, istnieją pewne ograniczenia do jej wykorzystania i stosowania w szczególności do takich ograniczeń należą specyficzne cechy licencjonowanego aktywa i okoliczności zawierania transakcji licencyjnej, które zawsze powinny być uwzględnione.

Żr: Zasada 25% w wycenie własności intelektualnych | Wycena przedsiębiorstw

Moim zdaniem największą wadą tego typu wycen jest ich podważalność, podobnie jak tak zwane ceny rynkowe, które też są podważalne, bo opierają na kontekście i danej chwili (moment wyceny). To sytuacja podobna to cen walorów na giełdzie: cena w momencie transakcji kupna/sprzedaży wynika wyłącznie z warunków panujących w danej chwili. Kupione walory mają cenę chwilową, taką jaką oferuje giełda w chwili dokonywania kolejnej transakcji. Problem w tym, że nie ma możliwości takiej wyceny w przypadku oprogramowania, bo nie ma takiej giełdy. Stosowanie więc metod nie mających, poza spekulacją, żadnego oparcia w faktach, powoduje, że wyceny takie sprawiają ogromne kłopoty i nazwa “cena z pod dużego palca” jest tu bardzo adekwatna. Zaryzykuje tezę, że takie wyceny wyrażają jedynie chciejstwo zleceniodawcy wyceny.

Dziedzinowa analiza pojęciowa

Ekspertyza, jeżeli ma być poprawna, musi być oparta na poprawnym: spójnym i niesprzecznym, modelu pojęciowym analizowanej dziedziny. Kluczowe pojęcia w tym przypadku to:

cena: wartość czegoś wyrażana w pieniądzach

źródło: Internetowy Słownik Języka Polskiego PWN https://sjp.pwn.pl/

dzieło: utwór literacki, naukowy lub artystyczny, zwłaszcza dużej wartości, efekt czyjejś pracy lub jakichś procesów

materialny: istniejący fizycznie, odnoszący się do dóbr ekonomicznych, dotyczący treści, a nie formy

niematerialny: nieodnoszący się do dóbr ekonomicznych

utwór: dzieło naukowe, literackie, muzyczne, filmowe itp.

wartość: to, ile coś jest warte pod względem materialnym

W artykule z 2012 roku, na powiązany temat: praw autorskich, opracowałem podobny model. We wstępie do opisu oprogramowania pisałem:

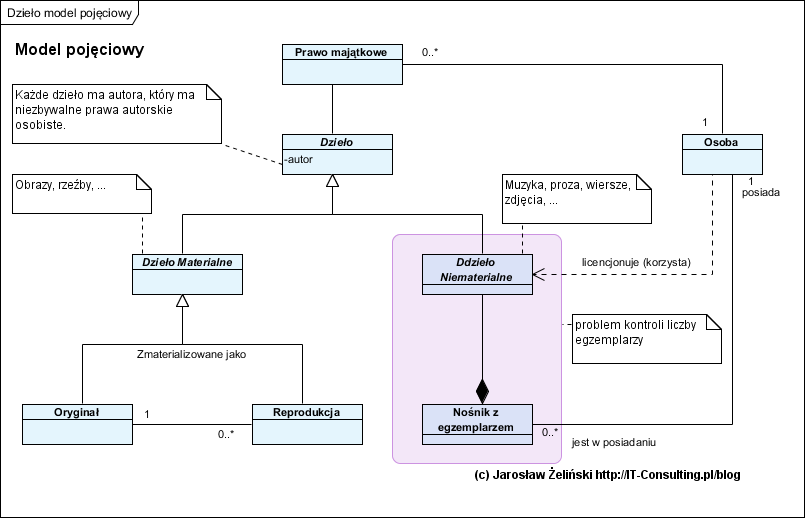

Dzieło może mieć postać materialną i niematerialną. Dzieło materialne (rzeźba, obraz malarski) ma swój oryginał, mogą powstać reprodukcje. To drugie dzieło, niematerialne, dotyczy w szczególności utworów muzycznych, zdjęć czy treści (każda wypowiedź to proza lub poezja ;)). Dzieło niematerialne może być utrwalone na wybranym nośniku (muzyka na płycie CD, proza na papierze, ?), wtedy powstają jego egzemplarze.

źr.: Prawo autorskie i wartości niematerialne – analiza systemowa

Model pojęciowy, wyrażony graficznie, przyjmuje postać:

Kluczowym elementem tego modelu, w omawianym kontekście, są pojęcia: dzieło niematerialne i nośnik z egzemplarzem. Dzieło niematerialne wymaga nośnika dla jego utrwalenia.

Komputer jest definiowany jako procesor, pamięć i program (ulokowany w tej pamięci), program (komputerowy) jest definiowany jako zestaw instrukcji dla procesora. Tak rozumiany komputer jest także określany jako uniwersalny mechanizm .

Podsumowując: dziełem jest każdy efekt czyjejś pracy, program komputerowy jest nim także. Komputer jako taki realizuje zaprogramowany mechanizm. Zestaw instrukcji dla komputera można wyrazić za pomocą kodu maszynowego “zrozumiałego wprost” dla procesora, ale można go wyrazić na dowolnym wyższym poziomie abstrakcji w postaci kodu programu wysokiego poziomu, a także jako opis wyrażony wzorami matematycznymi, algorytmami, schematami blokowymi . Biorąc to pod uwagę mamy łańcuch powiązanych treści:

program wyrażony jako wzory, schematy blokowe i algorytmy -> kod programu wysokiego poziomu -> kod maszynowy

W kategoriach prawa autorskiego są to kolejne utwory zależne (kod maszynowy jest generowany automatycznie z kodu programu wysokiego poziomu, robi to kompilator danego języka programowania).

Program komputerowy jest tekstem, którego autorem jest koder lub programista, dlatego prawo słusznie traktuje go jak dzieło literackie (utwór). Znaczy to, że jako treść, jest także dziełem niematerialnym. I tu pojawia się pytanie co wyceniamy? Potocznie programem (oprogramowaniem) nazywamy działająca aplikację stanowiącą czyjeś narzędzie pracy, w umowach oprogramowanie pojawia się jako przedmiot umowy, warto jednak wiedzieć, że sam program, bez procesora i pamięci jest tylko literackim tekstem, który owszem ma w sobie “zakodowany” określony mechanizm, jednak jest to wartość analogiczna do rysunków technicznych samochodu: zawierają precyzyjny opis tego jak ten samochód działa, jednak nie możemy na nich “pojeździć”: opis samochodu nie jest samochodem.

O co więc kruszymy kopie? O program, bo to jedyne co odróżnia komputery między sobą: wgrany program decyduje o tym jaki mechanizm realizuje komputer. Rynek komputerowy jest bardzo specyficzny bo kupując to co potocznie nazywamy komputerem, kupujemy procesor, pamięć oraz system operacyjny, który także jest programem. Jednak w tej postaci jest to dopiero platforma na której można uruchamiać kolejne kupione oprogramowanie: aplikacje użytkowe (np. system ERP).

Program komputerowy, by powstał, wymaga opracowania: należy go zaprojektować i stworzyć (zakodować). To jest praca wymagająca określonych umiejętności i czasu. To oznacza, że łatwo obliczyć koszt jego powstania: jest to wynagrodzenie twórców programu jako konsekwencja kosztów czasu ich pracy i wynagrodzenia oraz czasu jaki zajęło im wytworzenie tego kodu. Tak więc koszt powstania oprogramowania jest znany i łatwy do policzenia.

Problem pojawia sie wtedy, gdy podejmujemy próby tak zwanej rynkowej wyceny czegoś co jest unikalne (bo takie są niestandardowe programy). Przedmioty materialne, takie jak rzeźby czy samochody, są – podobnie jak programy komputerowe – dziełem ludzi, ich powstanie wymagało czasu i umiejętności. Jest jednak pewna różnica: kolejne egzemplarze samochodu czy rzeźby także wymagają pracy i umiejętności, a kolejne egzemplarze programu komputerowego nie: jego kolejne egzemplarze powstają praktycznie bez żadnej pracy jak wynik operacji takiej jak skopiowanie na kolejny nośnik. Podobnie jak e-book: kolejne egzemplarze to “copy-paste” na nośnik albo po prostu kolejne pobrania tego samego pliku z serwera dostępnego w sieci Internet. W efekcie znamy koszt powstania programu komputerowego i znamy koszt napisania książki. Jednak ich kolejne egzemplarze (książka jako e-book) powstają “bezkosztowo” (patrz na początku: wartość ekonomiczna).

Co więc w ogóle wyceniamy? Tu pojawia się kolejne pojęcie:

licencja: zezwolenie na korzystanie z czyjegoś dzieła chronionego prawem autorskim

Licencja należy do jednych z najbardziej trudnych ekonomicznie pojęć rozumianych jako opłata, gdyż ta jest w 100% umowna. Klasyczna ekonomia to wymiana: przedmiot za przedmiot lub przedmiot za czas (za pracę na rzecz tego, kto za nią płaci).

Dlatego z powodzeniem rozwija się na świecie idea oprogramowania oferowanego nie w modelu licencyjnym a na zasadzie: oprogramowanie to koszt jego twórcy, który pobiera jedynie wynagrodzenie za określona pracę na rzecz klienta: czyli stały rozwój oprogramowania i/lub pozostawanie w gotowości do wykonania pracy, czyli płatne wsparcie na żądanie zwane potocznie help-desk. Metody ustalania rynkowej ceny oprogramowania zostawię na inna okazję, tu pozostaniemy przy wycenie aktywów. Wycena oprogramowania standardowego (z półki) nie stanowi żadnego problemu: to jego cena na “sklepowej półce”.

Pozostaje do omówienia wycena oprogramowania dedykowanego bo jest z zasady unikalne a więc nie ma ono standardowej ceny. Niepodważalna wycena, to policzenie łącznych kosztów wytworzenia oraz późniejszego rozwoju. Pamiętajmy, że wsparcie jako usługa rozwiązywania problemów, nie podnosi wartości posiadanego oprogramowania, ale jego rozwój czyli dodawanie kolejnych funkcjonalności, owszem.

Wplatanie w to oszacowania, na ile to oprogramowanie przyczyniło się do osiągania zysków i jakich, jest pozbawione podstaw, bo zyski firmy zależą od inwencji kierujących nią. Tak samo jak dochody stolarza nie zależą od producenta piły (ta stanowi narzędzie pracy ale sama z siebie niczego nie zarabia) a dochody malarza od producenta pędzli. Tak samo dochody biura księgowego nie zależą od posiadanego oprogramowania wspomagającego księgowość. Owszem, bez narzędzi te firmy miały by problem np. z wydajnością, ale nie można powiedzieć, że jakiś producent oprogramowania mógłby uniemożliwić pracę biur księgowych (zakładam, że nie ma monopolu).

Na zakończenie

Tak więc skoro:

Próby potwierdzenia zasady 25% na danych empirycznych przynoszą umiarkowane efekty, choć wyniki uśrednione często koncentrują się w okolicach 25%, to zmienność uzyskanych wyników prowadzi do uzyskania w różnych branżach, różnych poziomów licencji, najczęściej w przedziale 10- 50% zysku operacyjnego.

to znaczy, że metody statystycznego szacowania wartości niematerialnych na bazie wartości dotychczasowych transakcji, są jedynie oceną historii tych transakcji, są giełdą czyli spekulacyjnym wartościami a metody tej nie należy stosować. Po drugie skoro oprogramowanie standardowe ma wyznaczoną cenę (koszt zakupu czyli koszt poniesiony) a dedykowane jest “każde inne”, to statystyki oparte na subiektywnych podobieństwach między programami i kosztami ich pozyskania są nieadekwatne jako narzędzie.

Świadomie nie cytowałem tu orzecznictwa, gdyż wywód powyższy w całości oparłem na fakcie jakim jest realna praca nad powstaniem oprogramowania. “Regułę kciuka”, którą przywołuje cytowany autor uważam, za czysta spekulację. Jeżeli jednak ktoś nie chce uznać faktu, że powstanie oprogramowania to skończona praca do wykonania, to pozostają mu tylko spekulacje i ryzyko, że ich wyniki ktoś podważy.