Wprowadzenie

Ukazał się ciekawy tekst: Odpowiedzialność cywilna za szkody spowodowane funkcjonowaniem sztucznej inteligencji – uwagi de lege lata i de lege ferenda – Wydanie – 11/2024 | Palestra . Szczególnie zainteresował mnie zwrot: “szkody spowodowane funkcjonowaniem sztucznej inteligencji”.

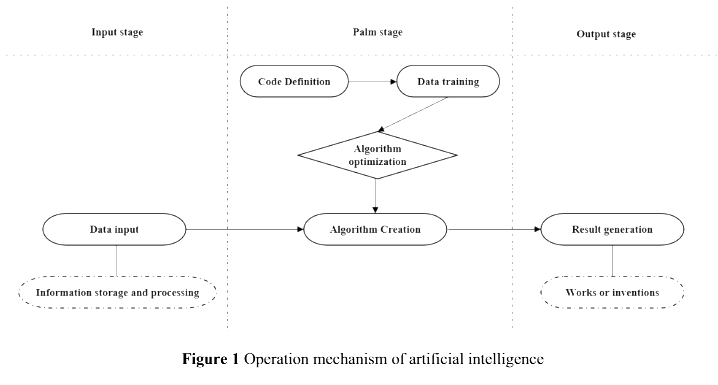

Czym jest “sztuczna inteligencja” (AI, ag. Artificial Intelligence)? Jest to “zdolność komputera cyfrowego lub robota sterowanego komputerowo do wykonywania zadań powszechnie kojarzonych z istotami inteligentnymi.”. Prof. Kisielewicz pisze wprost (polecam cały artykuł):

ChatGPT nie myśli, nie wnioskuje, niczego nie rozumie i nie jest żadną „sztuczną inteligencją”, o ile termin ten rozumiemy zgodnie z ideami ojców dziedziny artificial intelligence jako „autonomiczny program myślący na podobieństwo człowieka” – pisze prof. Andrzej KISIELEWICZ

W tym artykule nie będę się zajmował dyskusją czym jest inteligencja i sztuczna inteligencja, przyjmiemy powyższe definicje i poniższe wyjaśnienie:

Wszystkie, z wyjątkiem najprostszych ludzkich zachowań, są przypisywane inteligencji, podczas gdy nawet najbardziej skomplikowane zachowania owadów zwykle nie są traktowane jako oznaka inteligencji.[…] Psychologowie generalnie charakteryzują ludzką inteligencję nie przez jedną cechę, ale przez połączenie wielu różnych zdolności. Badania nad sztuczną inteligencją koncentrowały się głównie na następujących składnikach inteligencji: uczeniu się, rozumowaniu, rozwiązywaniu problemów, percepcji i posługiwaniu się językiem. (źr.: https://www.britannica.com/technology/artificial-intelligence)

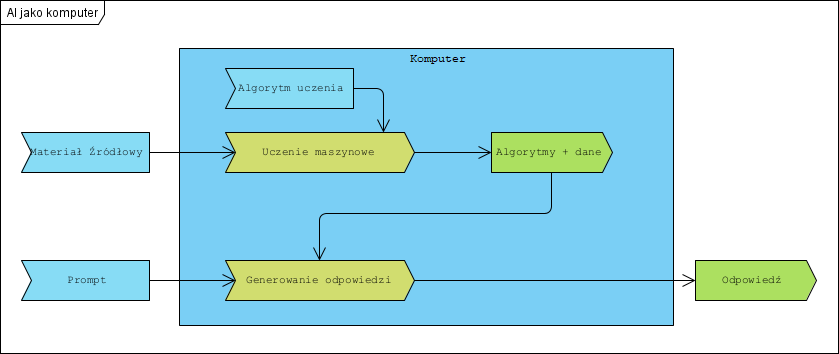

Generalnie jest to komputer, czyli procesor, pamięć i program . W tym przypadku określony program, którego funkcją jest “wykonywanie zadań powszechnie kojarzonych z istotami inteligentnymi” (patrz wyżej).

jeżeli

komputer = procesor + program + pamięć (dane)

oraz

AI = procesor + program + pamięć (dane)

to

AI = komputerPrzykład opisu tego faktu:

Powyższe można w uproszczeniu przedstawić tak:

Dwa ważne pojęcia:

- Podmiot prawa (podmiot prawny) – oznacza każdą osobę fizyczną lub osobę prawną utworzoną – i uznawaną za taką – na mocy prawa krajowego, unijnego lub międzynarodowego, która ma osobowość prawną oraz zdolność do czynności prawnych.

- Przedmiot prawa – rzecz, postępowanie, umowa itp., na które rozciągają się pewne normy prawne (tu będzie to komputer, materiały źródłowe, wynik pracy komputera)

Kluczowe jest tu także to, że:

- komputer nie myśli i nie jest podmiotem prawa

- komputer jest przedmiotem prawa, podobnie jak Materiał źródłowy czy Odpowiedź.

(źr,: https://prawo.uni.wroc.pl/sites/default/files/students-resources/Notatki%20-%20prawo%20cywilne.doc)

Polemika

Autorzy wychodzą z nieprawdziwego założenia, że

W świecie nauki, techniki i biznesu nie istnieje jedna powszechnie uznana definicja sztucznej inteligencji.

Ogólnie przyjęte i uznane definicje przytoczyłem we Wprowadzeniu, ewentualne inne to raczej spekulacje autorów wielu tekstów na podobne tematy, szczególnie fascynatów technologii i firm reklamujących swoje produkty w obszarze AI. Autorzy sami także przyznają, że:

Szczęśliwie, stosowane opisy tego pojęcia są dość spójne, a różnice między nimi nie są istotne z perspektywy przeciętnego uczestnika obrotu.

Autorzy piszą:

istotne wydaje się określenie kluczowych cech AI, aby móc dalej prowadzić rozważania dotyczące odpowiedzialności cywilnej w jej kontekście.

Generalnie AI to komputer i jego specyficzne oprogramowanie, ale jednak komputer czyli przedmiot prawa nie podmiot prawa. Bardzo niebezpieczne i zarazem nieprawdziwe jest także założenie autorów, że:

immanentną i najważniejszą cechą sztucznej inteligencji z perspektywy rozważań dotyczących odpowiedzialności cywilnej jest autonomiczność.

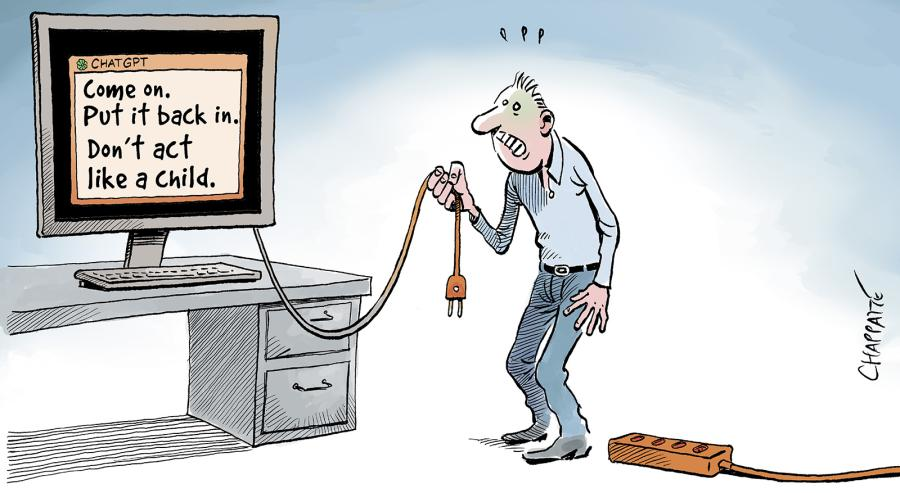

Otóż żaden komputer nie jest autonomiczny, z prostego powodu: powstał rękami człowieka, który zawsze może go po prostu “wyłączyć” (nie będziemy tu zajmowali się tym co pokazują filmy SF).

Jeżeli można mówić o autonomicznym komputerze to tylko wtedy, gdy człowiek traci zdolność kierowania nim, co ma miejsce np. w samosterującej rakiecie od momentu jej odpalenia, co nie zmienia faktu, że zaprogramował i wystrzelił ją określony człowiek (“winny”). Nawet jeżeli komputer (a konkretnie algorytm) ma wbudowane elementy losowego działania (np. algorytmy ewolucyjne) w jego zachowaniu, i faktycznie wynik jego działania nie jest w pełni przewidywalny, nie zmienia to faktu, że ta cecha (losowość) jest świadomą decyzją projektanta. Autorzy piszą, że:

ta cecha stanowi kluczową „operacyjną” różnicę pomiędzy narzędziami IT wykorzystującymi rozwiązania oparte na sztucznej inteligencji, a klasycznymi systemami IT.

Nie jest to prawdą: identycznie zachowują sie od wielu lat np. gry komputerowe i symulatory, jednak autorzy tu stawiają tezę tezę, że

sztuczna inteligencja wymaga odrębnego podejścia w kontekście odpowiedzialności cywilnej. Im bardziej sztuczna inteligencja jest autonomiczna, tym mocniej wymyka się tradycyjnemu rozumieniu kontroli nad środkami technicznymi.

uznając ją za aksjomat w swojej pracy.

Dalej pada kolejne ciekawe porównanie:

Tytułem przykładu wskazać można art. 431 k.c., który reguluje odpowiedzialność za szkody spowodowane przez zwierzęta,

jednak jak wiemy, zwierzęta z zasady nie są “winne” bo nie są podmiotem prawa. Jednak dalej piszą:

Trudno sobie bowiem wyobrazić, aby sztuczna inteligencja, jako taka, ponosiła „winę” za jakiekolwiek swoje „zachowania” i ich skutki. Z całą pewnością jednak może ona być przyczyną zaistnienia zdarzeń, które mogą prowadzić do naruszenia dóbr (fizycznych lub niematerialnych) innych podmiotów, co z kolei sprawi, że u tych podmiotów powstaną szkody. Sztuczna inteligencja może być zatem przyczyną powstania deliktu.

Innymi słowy nie ma różnicy między szkodą wyrządzoną przez psa i przez komputer, w obu przypadkach odpowiada powiązany z nimi człowiek (ogólnie podmiot prawa), co autorzy przyznają:

Należy przy tym zauważyć, że sztuczna inteligencja, jako taka, nie jest podmiotem prawa, ale jego przedmiotem (jednak nie jest rzeczą). Co do zasady za przedmioty prawa odpowiada ich właściciel (lub podmiot uprawniony), jednak w przypadku sztucznej inteligencji kwestia niekiedy nie wydaje się oczywista.

Powyższe zawiera jednak mały “haczyk”, autorzy piszą, że:

[AI] nie jest rzeczą

co nie jest prawdą: komputer jest “rzeczą” bo AI = komputer, a komputer to “rzecz”. Autorzy piszą:

Odpowiedzialność w obszarze sztucznej inteligencji jest w istocie zawsze – w większym lub mniejszym stopniu – związana przede wszystkim z odpowiedzialnością za działanie programu komputerowego.

Pozostaje ciekawostką co mieli na myśli pisząc “w większym lub mniejszym stopniu”.

Autorzy piszą:

Po drugie, sztuczna inteligencja może funkcjonować wyłącznie w sferze wirtualnej, jako element oprogramowania, albo w programie komputerowym powiązanym integralnie z rzeczą (jako element bezpieczeństwa albo program operujący tą rzeczą, jak np. robotem, dronem lub samochodem autonomicznym).

Nie jest to prawdą, AI to oprogramowanie czyli integralna część komputera. Dla komputera, który jest urządzeniem elektronicznym, oprogramowanie stanowi wyłącznie metodę skonfigurowania jego zachowania, jego złożoność niczego tu nie zmienia (ani samochód ani samolot nie są “inne” dlatego, że składają się z setek tysięcy elementów, a ich zachowanie dla wielu ludzi jest niezrozumiałe).

Kolejny groźny aksjomat autorów to:

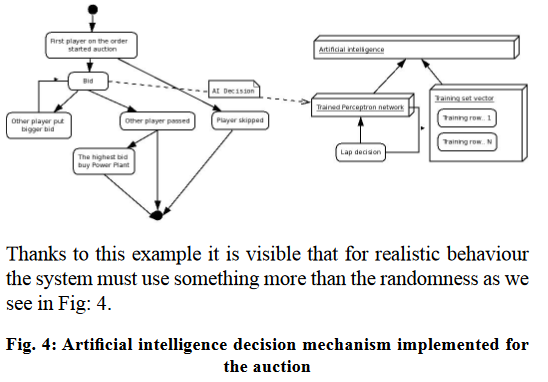

sztuczna inteligencja samodzielnie podejmująca decyzję

co także nie jest prawdą, bo “decyzje podejmowane przez komputer” to wynik działania programu (który ktoś napisał), bez względu na jego złożoność, zaś komputer nadal jest “rzeczą” w rękach jego użytkownika: człowieka. Poniżej przykład “podejmowania decyzji” przez AI:

W efekcie stwierdzenie:

Pewien problem pojawia się jednak w sytuacji, kiedy to sztuczna inteligencja „samodzielnie” – tj. bez bezpośredniego udziału i woli człowieka – wywoła jakieś zdarzenie faktyczne, którego skutkiem będzie szkoda danego podmiotu.

Jest nieprawdziwe. Autorzy piszą:

Podmiotów, którym mogłaby zostać potencjalnie przypisana odpowiedzialność, jest na pierwszy rzut oka tak dużo, że wyzwaniem może okazać się wskazanie tego właściwego (projektant algorytmów, producent, podmiot wdrażający lub trenujący model AI czy użytkownik końcowy), a regulacje prawne nie pokrywają (lub pokrywają niekompletnie) całego wachlarza zdarzeń mogących wywoływać u danego podmiotu szkodę w związku z działaniem sztucznej inteligencji.

Co także nie jest prawdą: zbudowanie łańcucha zdarzeń od faktu wyprodukowania komputera do faktu powstania szkody z pomocą tego komputera, nie jest trudne.

Autorzy na bazie przyjętych przez siebie aksjomatów, wywodzą:

W naszej ocenie przyjęcie zasady odpowiedzialności w kontekście AI wymaga podejścia funkcjonalnego i powinno być determinowane przede wszystkim stopniem autonomiczności danego narzędzia AI.

Jak wyżej wskazałem AI nie jest autonomiczne i można wskazać podmiot będący dysponentem komputera. Co jednak ciekawe, dalej piszą:

Praktyka i nauka prawna są dość zgodne, że dla AI o wysokim poziomie autonomiczności zasada winy często może być nieadekwatna (operator czy producent AI nie powinien móc uwolnić się od odpowiedzialności w wypadku, kiedy model sztucznej inteligencji zachował się inaczej, niż było przewidziane).

Pisza dalej:

Tymczasem, nie uciekając się do dyskusji de lege ferenda, które są tyleż interesujące, co niewystarczające z uwagi na teraźniejsze potrzeby obrotu, prawo daje pewne podstawy, które należy wykorzystywać w kontekście AI – instytucje odpowiedzialności za pojazd i za przedsiębiorstwo wprawiane w ruch za pomocą sił przyrody. Można przyjrzeć się także odpowiedzialności za szkody wyrządzone przez zwierzęta jako intrygującej (i kontrowersyjnej) opcji do wykorzystania wobec AI, do której można sięgać przez analogię. Ponadto trwają już także prace nad specjalnymi przepisami dot. odpowiedzialności za AI jednolitymi w całej Unii Europejskiej, które również zostaną tutaj omówione.

Autorzy próbują podważyć analogię AI do zwierząt co nie ma jednak żadnej podstawy. AI, podobnie jak zwierzęta, cechuje się pewną autonomicznością po “wypuszczeniu z ręki”, jednak niczego to nie zmienia: ani zwierzęta ani AI nie są podmiotem prawa, najczęściej można wskazać ich właściciela/opiekuna czyli odpowiedzialnego za nie i ich zachowania. Autorzy twierdzą, że:

Niezbyt oczywista, ale warta rozważenia, jest możliwość zastosowania do sztucznej inteligencji art. 431 k.c. – przepisu konstruującego odpowiedzialność za posiadane zwierzę.

jednak nie uzasadniają swojego stanowiska, a to, że AI nie jest żywym stworzeniem nie ma znaczenia: mamy “rzecz”, która “coś robi” i ta “rzecz” ma przyporządkowaną za te zachowania odpowiedzialną osobę (podmiot prawa).

Pozostała część publikacji jest oparta na przyjętych przez autorów aksjomatach, jednak podstawy ich przyjęcia, co wskazałem wyżej, nie mają podstaw logicznych, są raczej “założeniem przyjętym bez uzasadnienia” ale jako dogmat autorów.

W podsumowaniu autorzy sugerują, że “należy coś z tym zrobić”:

Prawny ekosystem odpowiedzialności cywilnej za AI jest mocno pofragmentowany. Pewne istniejące instytucje wydają się być gotowe na nowe wyzwania rzucane przez sztuczną inteligencję. Inne wymagają drobnych modyfikacji, a czasem po prostu otworzenia na AI. Stoimy także w obliczu obszarów, które mogą ulegać istotnym przeobrażeniom, zwłaszcza w wyniku działań legislacyjnych Unii Europejskiej.

Moim zdaniem, co pokazałem wyżej, najlepiej nie robić nic, tak jak się to dzieje od początku ery informatyki. To, że coś wymyka się pojmowaniu coraz większej liczbie ludzi (jest to naturalny efekt postępu techniki) nie znaczy, że “należy coś z tym robić w prawie”.

Polemika ta została wysłana do wydawcy cytowanego tekstu.

Pytania czytelników

(poniższe komentarze to eksperckie uwagi autora a nie porady prawne)

- Fajnie napisane. Zgadzam się. Natomiast mieliśmy ostatnio dyskusje jak to jest z prawem autorskim. Jeżeli sztuczną inteligencją (czy tam jej algorytm po prostu) stworzy obraz. To kto ma prawa do tego obrazka. Użytkownik? Autor modelu? Używając takiego Photoshopa jest to w miarę jasne. A jak to jest np z GPT ? Jakby nie patrzeć składa go z innych znanych mu obrazów

- Co do zasady mamy tu parę “człowiek + narzędzie”, przedmiotem prawa autorskiego jest utwór a podmiotem jego autor zaś to jakiego używa narzędzia nie ma znaczenia, boto on (jak za psa) odpowiada za skutki, tu treść utworu. W przypadku prawa autorskiego to pokrzywdzony musi wykazać, że ktoś łamie jego prawa (plagiat). AI – poza stopniem komplikacji” – nie różni się od np. Photoshopa. W tym ostatnim biblioteka używanej gotowej grafiki (zdjęcia, grafiki, itp.) wymaga licencji. W AI są to generowane losowo obrazy z wzorców, a te zostaną w sądach potraktowane raczej jako “źródło inspiracji”. W efekcie człowiek używający narzędzi AI jest autorem uzyskanego efektu, zaś to czy jest to plagiat czy nie (naruszono czyjeś prawa) musi zostać udowodnione każdorazowo.

- Może by warto dodać też w tekście, bo to do końca chyba czytelne dla czytelnika może nie być ze zapis licencji może odpowiedzialność przenosić na użytkownika w jakimś tam stopniu. Na bank mało kto czyta regulamin takiego GPT. Nie jest to clu rozważań ale jakimś tam zwróceniem uwagi.

- Jak wyżej, licencja jest potrzebna na AI jak na każde inne oprogramowanie, co do reszty tylko wtedy, gdy wprost używamy cudzego utworu i nie jest to “cytowanie”. PhotoShop to oprogramowanie a biblioteki np. zdjęć to dodatkowe licencjonowane produkty. Jeżeli uznać, że AI “istotnie przetwarza” cudze obrazy czy teksty zostanie to zakwalifikowane jako inspiracja, a tego zabronić nie można.