#1 - a 3d render series showing change and motion

Od czasu do czasu w zakresie wymagań biznesowych pojawiają się (coraz częściej) potrzeby z obszaru szeroko rozumianego kontrolingu, który polega na zbieraniu danych w celu tworzenia wyrafinowanych raportów, bazujących na danych z wszystkich obszarów organizacji. Dzisiaj kilka słów na ten temat, bo z moich nieformalnych (rozmowy i dokumenty projektowe u klientów) badań, wyłania się obraz wielu nieudanych wdrożeń hurtowni i aplikacji zwanych Business Intelligence, nieudanych z powodu małej ich wydajności, małej przydatności (najczęściej, tak!) lub obu naraz. Artykuł podzieliłem na dwie części: Troszkę o teorii... i Troszkę o tym z…

W wielu firmach system zarządzania jest tak niespójny, że jedynym sposobem funkcjonowania tych firm, jest łamanie zasad przez jej pracowników. Niestety pierwsza wpadka często powoduje załamanie się całego systemu (a nie raz i firmy). Wiele Zarządów firm nie zdaje sobie nawet sprawy z tego, jak duże jest ryzyko ciągłości funkcjonowania ich firm.Tak więc model procesu to nie algorytm działania firmy, wykazano nie raz, że algorytmizacja pracy ludzi jest niecelowa (wtedy stosujemy roboty).Znaczna część tego co robią ludzie to efekt ich kompetencji, wiedzy i doświadczenia, a nie dyktowania im jak mają wykonywać swoja pracę.Jeżeli wybierzemy drogę modelowania tego wszystkiego diagramami, to ilość tych diagramów szybko przekroczy granicę sensy całego projektu: nie będą czytane. Ich wartość będzie żadna.W procesie dobrze przygotowanej analizy (jakiejkolwiek) modele tworzy się by je badać, a nie tylko po to by powstały za pieniądze sponsora projektu.Należy też nabrać pokory: większość organizacji sprawnie funkcjonuje nie mając żadnych modeli procesów, więc teza, że ich brak szkodzi jest nie do obrony. Po co więc te modele? Żeby zrozumieć dlaczego tak jest i co się stanie, gdy zechcemy wprowadzać zmiany.

Technologia IT pozwala zapisywać ogromne ilości danych. W cytowanym na początku artykule namawia się nas na inwestycje w technologie, które dają szanse na "przerobienie" tego. A czy aby na pewno musimy gromadzić to wszystko? Mózg ludzki ma doskonała obronę przed nadmiarem informacji, jak wiemy radzimy sobie całkiem nieźle mimo tego, że wiele rzeczy zapominamy. To miliony lat ewolucji stworzyły ten mechanizm! Wystarczy go naśladować.Zmierzam do tego, że projektowanie systemów informatycznych to także projektowanie tego jakimi danymi zarządzać i które zachowywać np. w hurtowni danych. Gdyby nasza firma zawierała nieskończoną ilość transakcji sprzedaży rocznie (:)) czy musimy analizować wszystkie by ocenić udziały w rynku, podział na regiony, najlepszych i najgorszych sprzedawców, nadużycia w transporcie? Nie! wystarczy mieć dane reprezentatywne, rejestrować do analiz tylko ustalona część ([retencja danych]]). Niestety nie jest łatwo podjąć decyzje, która to część i to jest (powinno być) tak na prawdę część analizy wymagań. A koszt takiej analizy nijak się nie ma, jest znacznie mniej kosztowna, niż systemy do przetwarzania wszystkich tych danych. Nie dajmy się zwariować z wydatkami na rosnące pojemności systemów składowania i przetwarzania danych.

Warto tworzyć dobrze przemyślane systemy metadanych dla systemów archiwizacji gdyż pozwala to z jednej strony "spiąć" archiwum dokumentów z hurtownią danych z drugiej "pozbyć się" śmieci. Tempo przyrostu danych stale rośnie gdyż biznesowe oprogramowanie, automatyzując wiele naszych czynności, wytwarza je w tempie w jakim człowiek nigdy nie był by w stanie. Po drugie narasta zjawisko powielania, co nazywam to syndromem "copy&paste". Wiele dokumentów (o zgrozo także tych podobno "autorskich") i powstaje coraz częściej metodą powielania tego co znajdzie się w firmowych archiwach (wiedza korporacyjna czyli po prostu jej zanik, bo wiedza to umiejętność napisania czegoś a nie skopiowania) czy w sieci.

Moja praktyka (to co dostaje do audytu u klientów) pokazuje, że dokumenty wytworzone "od zera" praktycznie zawsze mają większą wartość merytoryczną. Do tego dochodzi ryzyko przeniesienia, podczas kopiowania, treści niechcianych. Kopiując dziesiątki stron "starej oferty" lub poprzedniego "opracowania doradczego", tworząc kolejne "indywidualne autorskie opracowanie" narazić się można nie tylko na ujawnienie tajemnicy ale także na zwykłe ośmieszenie. Dlatego system zarządzania dokumentami i wiedzą należy dobrze zaprojektować. W przeciwnym wypadku narażamy się na budowę wielkiego śmietnika.

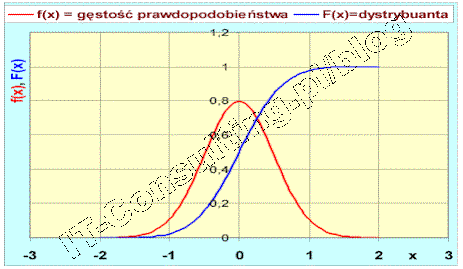

Dlatego hurtownie danych i tak zwane systemy Business Inteligence, wszelkie systemy wspomagania decyzji, to albo analiza historii albo prognozowanie oparte na modelach. Owszem analiza historii to także analiza korelacji ale to inny temat :). W kwestii marketingu lepiej jest, moim zdaniem, opracować model zjawiska, jednak do tego nie potrzebne są duże ilości danych a jedynie minimalny [[zestaw danych reprezentatywnych]] i to się nazywa zasadą ekonomii myślenia. Wielką zaś sztuką projektowania hurtowni danych dla systemów BI, nie jest samo gromadzenie danych a właśnie ich odsiewanie, dlatego systemy analityczne integrowane z systemami CRM bywają czasem bardziej szkodliwe niż pomocne.

Mamy przyjemność zaprosić Państwa na II edycję bezpłatnej konferencji, która jest szansą na uzyskanie lepszych wyników i przewagi nad konkurencją. Konferencję Knowledge Management ? systemy wspomagające zarządzanie wiedzą GigaCon kierujemy do osób decydujących o sposobie funkcjonowania przedsiębiorstwa, odpowiedzialnych za zarządzanie przepływem informacji, zarządzanie wiedzą oraz dobór rozwiązań i technologii służących wspieraniu tych procesów; osób odpowiedzialnych za optymalne wykorzystanie posiadanych zasobów wiedzy. Tematyka konferencji: - Systemy zarządzania dokumentami (document management) - Systemy obiegu pracy (workflow) - Systemy wspomagania pracy grupowej (groupware) - Hurtownie danych (data warehouse) - Portale korporacyjne (enterprise portals)…

W obecnej ekonomii jedne firmy przegrywają inne osiągają sukcesy. Jeśli chcesz być jednym z tych, którzy osiągają sukcesy musisz umieć zaadresować każde swoje działanie na rynku. Jedną z podstawowych zasad strategii rynkowych jest właściwa segmentacja rynku. Podobno wie o tym każdy menedżer i niestety prawie każda firma próbuje powiększać przychody zaniedbując te zasadę. Jak na rynku adresować swoje produkty?

Z danymi jest troszkę tak jak z pieniędzmi i ludźmi: samo posiadanie pieniędzy z nikogo jeszcze nie uczyniło wielkiego człowieka co nie zmiania faktu że wielu stale i za wszelką cenę próbuje tylko mieć dużo pieniędzy. Posiadanie dużej ilości danych (w hurtowni) nie czyni z nich ani wiedzy ani narzędzia wspomagającego podejmowanie decyzji.

(więcej…)

Okres wakacyjny (kiedy to było …) zaowocował stosem zaległej literatury…. Dziś przyszła pora na zaległe numery Software Developer Journal. Czasopismo adresowane głównie do programistów i architektów ale jako analityk i ja także znajduje tam nie raz coś ciekawego.

(więcej…)